El pasado viernes 14 de noviembre, Javier Ferrer, profesor de la Universidad de Málaga y miembro del equipo de investigación del proyecto SOFIA, presentó en el congreso IDEAL 2025 el trabajo titulado «Influence of External Dependency Retrieval and Prompt Engineering in Test Case Generation using LLMs».

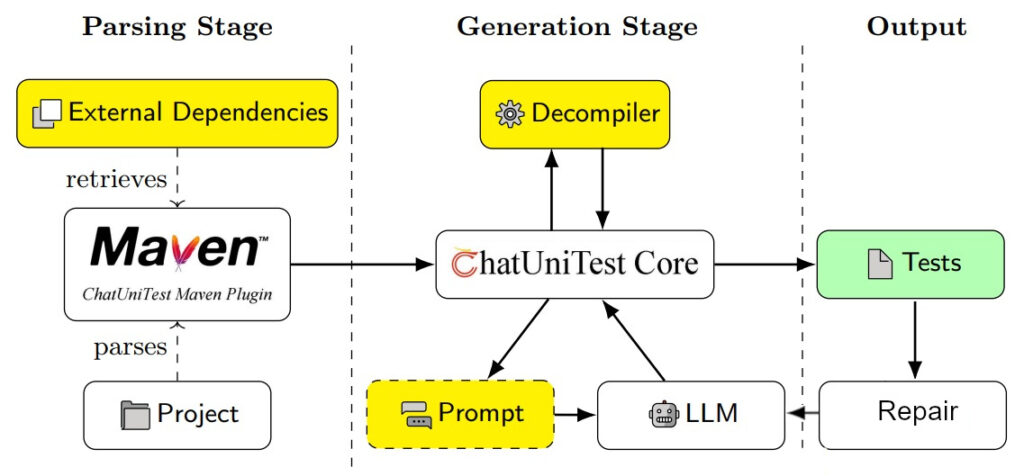

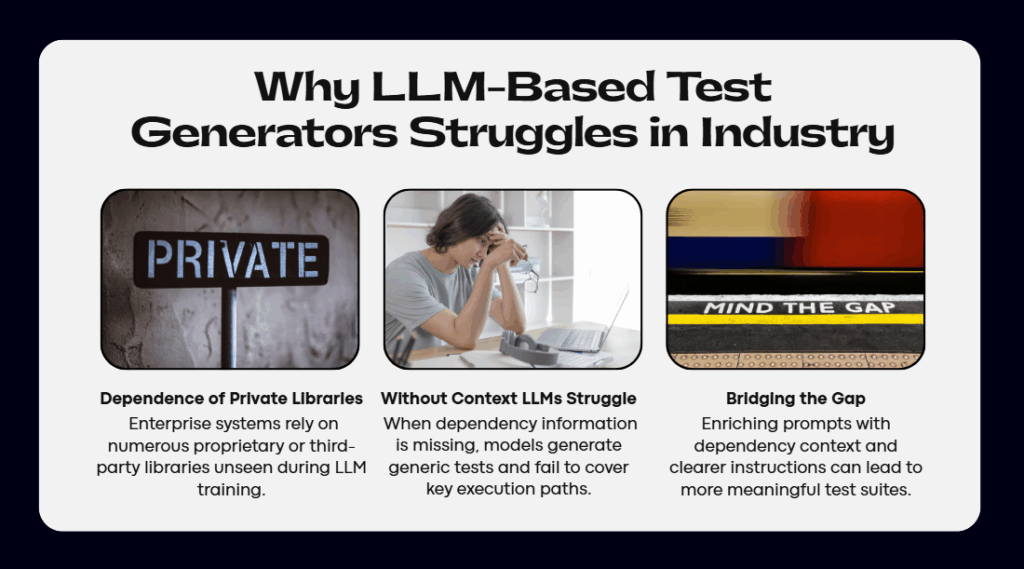

Este trabajo, desarrollado en el contexto del proyecto SOFIA y con colaboración de Ayesa, propone una mejora del estado del arte sobre el uso de LLMs para la generación automática de pruebas unitarias en Java. En particular, el trabajo parte de la herramienta ChatUniTest y la modifica para incluir más información de contexto al LLM para que sea capaz de generar casos de prueba con una mayor probabilidad de que compile y con una más alta cobertura.

El contexto adicional proporcionado consta de una versión decompilada de las dependencias que el método bajo prueba utiliza. Adicionalmente, el estudio propone un nuevo prompt para el LLM que consigue mejores resultados.

La evaluación experimental, sobre proyectos open source y empresariales, muestran que ambas propuestas (la ampliación de contexto y la optimización del prompt) tienen un impacto positivo en la cobertura de código obtenida.

Referencia:

Lenke, D., Ferrer, J., Chicano, F. (2026). Influence of External Dependency Retrieval and Prompt Engineering in Test Case Generation Using LLMs. In: Martínez, L., et al.Intelligent Data Engineering and Automated Learning – IDEAL 2025. IDEAL 2025. Lecture Notes in Computer Science, vol 16238. Springer, Cham. https://doi.org/10.1007/978-3-032-10486-1_15

El trabajo se ha publicado en el volumen 16238 de la serie Lectures Notes in Computer Science de Springer y se puede localizar siguiendo este enlace (https://doi.org/10.1007/978-3-032-10486-1_15).